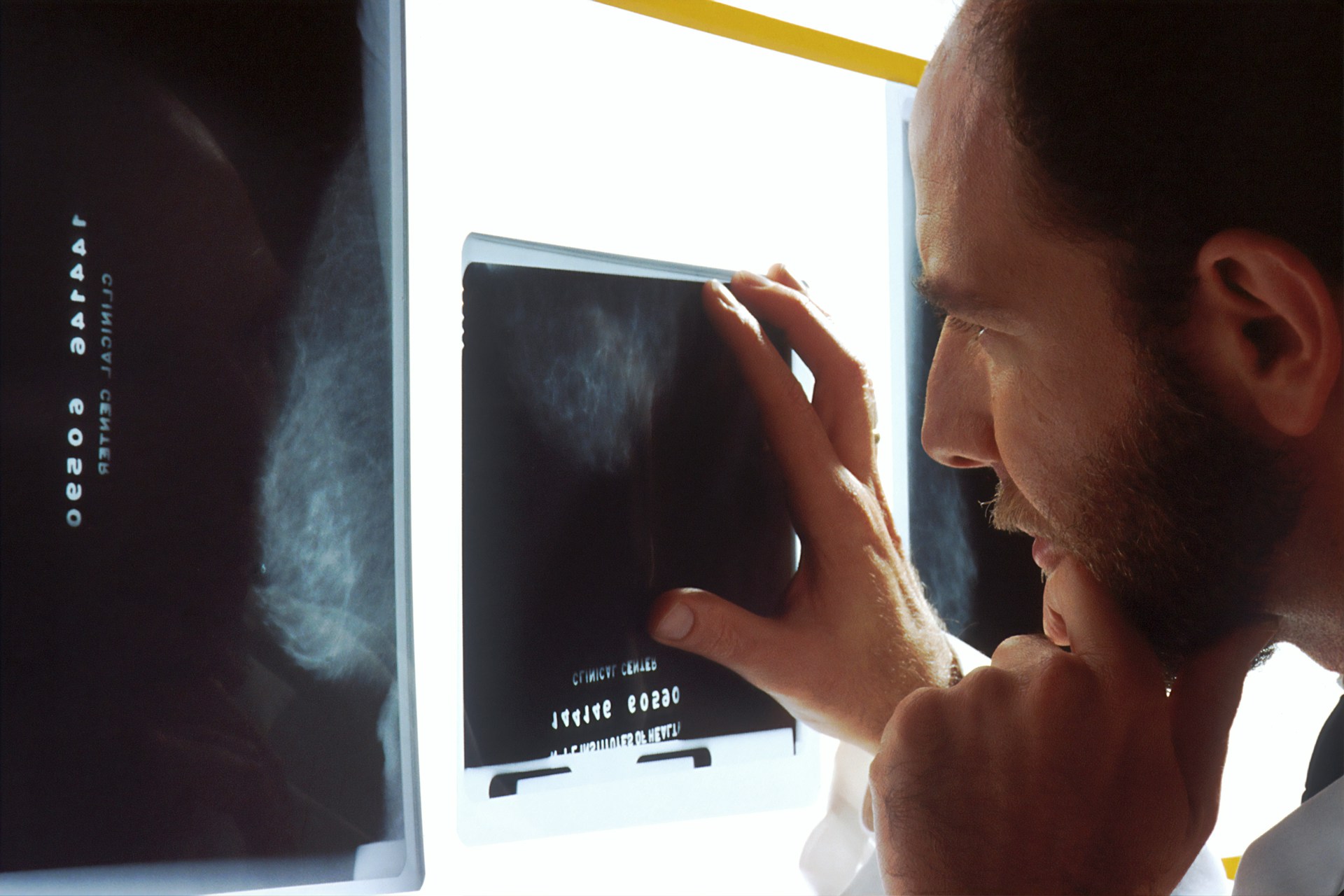

Si l’intelligence artificielle progresse à pas de géant, ses capacités en imagerie médicale ne sont pas encore au niveau des attentes cliniques. Chat-GPT4 Vision, le premier modèle de langage capable d’interpréter à la fois texte et image, montre des résultats prometteurs en radiologie… mais aussi des limites importantes, notamment en lecture d’images.

Une IA multimodale, conçue pour assister les professionnels

Une étude rigoureuse pour tester Chat-GPT4 Vision

Une équipe américaine a soumis Chat-GPT4 Vision à 377 questions extraites d’examens de formation en radiologie diagnostique, dont près de la moitié comportaient des images. Le modèle a obtenu 65,3 % de bonnes réponses au global, mais avec une forte disparité :

-

81,5 % sur les questions textuelles,

-

47,8 % sur les questions visuelles.

Compréhension textuelle : un point fort indéniable

Lorsqu’il s’agit d’analyser une information écrite, Chat-GPT4 Vision est performant. Il peut :

-

synthétiser des rapports,

-

vulgariser des données complexes,

-

et assister dans la rédaction médicale.

Autrement dit, l’outil peut soutenir le travail documentaire du radiologue.

Lecture d’images : des performances très inégales

Face aux images, la performance chute. Si les résultats sont corrects pour certaines spécialités comme la radiologie thoracique (jusqu’à 69 %), Chat-GPT4 Vision échoue quasi totalement en médecine nucléaire.

Les causes :

-

Analyse visuelle limitée,

-

Manque de formation médicale spécifique,

-

Hallucinations (erreurs plausibles mais fausses).

Hallucinations : un risque clinique à ne pas sous-estimer

Certaines réponses erronées sont données avec assurance. C’est là que réside le danger : des interprétations fausses mais convaincantes, difficiles à détecter pour un non-spécialiste.

Cela souligne que la lecture radiologique reste une compétence médicale contextualisée, difficilement modélisable à l’identique.

Le rôle des invites : un levier de performance limité

Les chercheurs ont testé plusieurs types de formulations pour voir si le “prompting” améliorait les résultats :

-

invite simple,

-

raisonnement par étape (“chaîne de réflexion”),

-

formulation longue.

Résultat : légère amélioration uniquement sur les questions textuelles. Sur les images, aucune amélioration notable. Pire, Chat-GPT4 Vision a refusé de répondre à plus de 120 questions, la plupart incluant des images.

Un potentiel réel… mais à manier avec prudence

Points positifs :

-

Bonne maîtrise des contenus textuels,

-

Utilité potentielle pour la pédagogie ou l’aide documentaire.

Limites actuelles :

-

Lecture d’images instable,

-

Risques d’erreurs graves,

-

Refus de réponse fréquents.

Vers une IA radiologique de confiance : quelles perspectives ?

Pour aller plus loin, il faudra :

-

intégrer des bases de données spécialisées en radiologie,

-

former l’IA avec des cas cliniques validés,

-

encadrer les usages avec des garde-fous.

Le développement d’IA en radiologie est une voie d’avenir, mais qui exige rigueur, éthique et validation scientifique.

En conclusion

Chat-GPT4 Vision ne remplace pas le radiologue. Il peut assister, documenter, vulgariser… mais il ne voit pas. Sa fiabilité en imagerie médicale reste à construire. Pour l’instant, la prudence s’impose.